Съвети за правилна употреба на файла - devaka SEO блог

В един от неговите туитове, споменах, че robots.txt е зло и какво е то, толкова повече да навреди го носи на сайта. Сблъсквайки се с голямо объркване, включително момента, в който не са единодушни оптимизатори ясни по този въпрос, когато някои уебмастъри използват старите препоръките, искам да направя някаква яснота при използването на този файл в настоящата среда.

Ясно е, че на различните директиви се използват в robots.txt. Сред тях има много полезни:

Има и директива на Disallow (и Позволете обратното). Тя е за тях и ще бъдат обсъдени в тази статия.

Какви са проблемите на уебмастъри, използващи robots.txt?

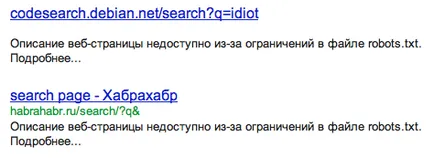

Първият и основен проблем на уебмастърите, е наличието в индексни страници на Google, които са били затворени в robots.txt. Смята се, че ако затворите страница или раздел в robots.txt, тя няма да падне в индекса, или да се откаже от него, ако е имало. Това е точно това, което работи добре за Yandex, Google robots.txt възприема по различен начин.

За да затворите страниците на дублиращи се използват по-добре CMS вътрешноправни средства за защита. и да не се опитват да направят живота ви по-лесно от robots.txt. Освен това, този файл може, по някаква причина, да не е налична (преместен на друг сървър, забравени, преименува и т.н.) и в този случай всички затвори рязко става отворен (може би, както в случая с предишния теча от wiki.yandex-отбор .ru).

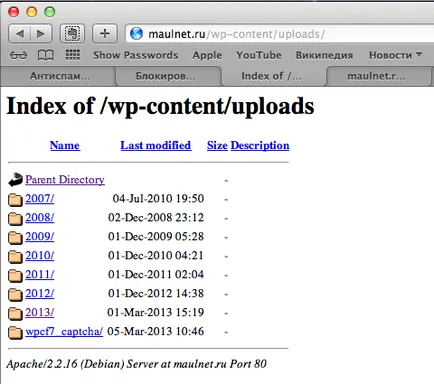

На второ място, като затвори всичко, можете да затворите случайно важните неща. Например, затваряне на WordPress цяла папка / WP-съдържание /. Можете да остане без движение в изображения, които се съхраняват в / WP-съдържание / качени /.

Тук се съхраняват на изображението, но на снимките не се е да търсите:

Така се оказва, е по-добре да не се използва robots.txt? В някои случаи тя все още е полезно (особено когато предписват първичното огледало за Yandex).

Това, което препоръчваме да използвате robots.txt

- За да затворите целия сайт по време на своето развитие

За да преминете в индекса не е нищо повече. - За да затворите сайта от търсачките останали.

Например, местата на RuNet няма смисъл да се покаже в Yahoo! Ако търсачката не е целевата аудитория, можете спокойно да затвори сайта, така че да не допълнителния натиск на техните сървъри. - За да затворите частните секции на сайта, от очите на робота.

За лични данни (като например номера на кредитни карти или пароли 🙂 SMS-потребители) не попадат в индекса. Докато логично тези секции не трябва да се отвори сайта. - За да премахнете натоварването на сървъра

Ако, например, на много популярни сайта си в продължение на много функционални sotrirovke стоки или каквито и филтри, които изискват повече ресурси на сървъра, не можете да споделите с робота до тези страници, за да поеме тежестта. Въпреки че, отново, за вход ще направи сортиране функционалност невидим за самия робот CMS. от смяна отговорност за файла robots.txt.

Това, което аз не бих препоръчал използвате robots.txt

- За да затворите прелистване на индексни страници, сортиране, търсене

От повторенията трябва да се изхвърлят CMS инструменти. например, 301 пренасочване. етикет отн = каноничен (което е специално за е създадена тази цел), 404 или мета тагове роботи Noindex. - За да изтриете съществуващите страници в индекса

Често срещана грешка уебмастъри, когато те се опитват да премахне страницата от роботи на индекса. Той няма да бъде в състояние да се възстанови индексира страницата и да го изтриете, ако сте близо достъп до него чрез роботи. - За да затворите администраторския панел

от администратор път се вижда в роботи. Така че по Optimization.by конференция, колегите ми и злонамерено да получат достъп до един с администратора на сайта за курсова работа, по пътя към които научих през robots.txt и пароли са били стандарт администратор: администратор. - За да затворите другите страници, които не искате да видите на индекса

Използването на други методи

SEO-анализатор, консултант. Винаги в крак с новите тенденции на пазара на SEO.

"Ако търсачката не е целевата аудитория, можете спокойно да затвори сайта, така че да не допълнителния натиск на техните сървъри."

Ако товарът да се страхуват от броя на посещенията от някои търсачки - това е колко трябва да отидете на народа на тази търсачка на сайта на някои заявка? В този случай, хората, интересуващи се от ключови думи, но на сайта не се интересува от тези хора?

Ян. ако на хората добро. Въпросът е, че търсачката на първите индекси на сайта. И за известно време Yahoo! са индексирани от много агресивно, понякога отиде до сървъра. Ето защо, ние излезе с директива обхождане закъснение. Ето описание по-скоро технически проблем, а не на потребителите.

Правилно ли съм разбрал по отн = 'каноничен "?

1. Ако един блог има 100 страници, тип на първични, но по-стари публикации, на всяка страница (страница 1, 2, 3) трябва да бъде връзката URL на главната страница, а в по-голямата си прекалено?

Или просто даде URL предимно за себе си, и всичко, което харесвате?

2. Аз просто не мога да разбера как това REL Canonical.

Например: Имам 20 страници, всичко сочи относителна връзка и Canonical URL от 1 страница. За Google, това означава, че индексът трябва само една страница? Така ли е?

но може би в robots.txt не е необходимо да се определи домакин, който не знае домакин е първичното огледало сайт, аз съм тук, след като не е регистриран и имам сайта индексиран с друго огледало

И може да се каже, с помощта на екип може да блокира достъпа до определени постове сайт индексирането му на входа и гостите (ще бъде достъпна само за администратора)

Казвате, че използването на robots.txt лошо, защото можете да направите беля в следствие на собствената си глупост - това е разбираемо. Вторият ключов минус robots.txt - Google все още индекси. Прав ли съм да улови същността на роботите недостатъците?

Като се започне от тези недостатъци, аз престане да се разбере по-нататъшни изводи в статията.

1. ви препоръчваме използването на robots.txt, за да затворите чрез индексиране с лична информация на страницата (например, страници с номера пластмасови карти). Така че, тъй като индексът ни воля е все едно?

Четох и реши, че най-доброто, дори няма да я докосне. Как да направите така, нека да бъде. И как няма да стане по-лошо.

Ако има някакви прекъснати връзки, че е по-добре да се направи? Напиши ги в robots.txt като Disallow: или да изчакате за индексиране? Google и Yandex понижава рейтинга на прекъснати връзки?

Това, което не го затворите, атрибути, както и други приспособления. Ние играем на терена и canids по техните правила. Яша - собственик на ресурса, и е по-добре да не показва твърде много, и в този случай ще (известен още като търсачка), и наказват. Аз съм на хостинг - безплатен курс и всички връзки са затворени прословутия атрибут. Наскоро, по някаква причина, те започват да се появяват в Бека JMM. Чрез целия код на двете места - на хостинга не почистват nofollou. Накратко куче pofigu от хоста, nofolou, noindeks и др. Pofigu yuzverg, той носи парите за всички нас и за него!

Имате право да играят честно, защото не е в състояние да победи априори!

Robots.txt погледна вашия сайт. Тя е малко по-различно от посоченото в статията. Аз разбирам, че на мястото, не струва нищо. Промените се случват, когато значителна, а когато не.

Аз бях най-голям интерес в маркера близо или не да се затвори?

Хмм ... Кажи ми, yukoz казва на всички, че той robots.txt настроен перфектно, независимо дали това е вярно или всичко е едно и също необходимостта да редактирате.

Може да се препоръча използването на robots.txt, за да затворите чрез индексиране с лична информация на страницата (например, страници с номера пластмасови карти). Така че, тъй като индексът ни воля е все едно?

Има страници, които не могат да получат някой отвън (без връзки), с изключение на лична информация на собственика. Ако тези страници не са затворени, то може да се индексира от търсачките (както е в случая с нещо като MegaFon, ако си спомняте тези демонтаж).

В крайна сметка, чрез позоваване относителен = "канонични" може да бъде само страница е почти идентично съдържание. Когато прелистване на втора страница ще бъде нещо съвсем различно от това в първата.

Да, прав си, страницата ще бъде различна, но все пак Canonical може да се използва и в такива случаи, той ще работи. Друго нещо е, че преди няколко дни Google не се препоръчва да се използва този етикет за виртуална памет, да. тагове вместо предлага отн = предишна и отн = следващия.

Ако има някакви прекъснати връзки, че е по-добре да се направи? Напиши ги в robots.txt като Disallow: или да изчакате за индексиране? Google и Yandex понижава рейтинга на прекъснати връзки?

Неработещи връзки от сайта или в твоята? По принцип най-добре е да се свържете с уеб администратора и да направи невалидни връзки не са повредени. Ако това не е възможно, тогава се създаде в собствената си CMS (или сървър), че най-прилеп връзка предал полезна информация (най-малко 404 страница с богат избор на други опции страници).

Аз бях най-голям интерес в маркера близо или не да се затвори?

Ако тези страници не носят добавена стойност на обекта (с изключение на навигацията), не е дори близо, както и премахване от сайта. Но това IMHO.

Yukoz казва на всички, че той robots.txt настроен перфектно, независимо дали това е вярно или всичко е едно и също необходимостта да редактирате.

Тук аз не подкани с ucoz не е работил. Във всеки случай, трябва да се провери дали всички сте конфигурирали правилно.

Уважаеми Сергей, благодаря ви много за статията. Вие сте добре, разбира се ... Моят въпрос е: Имам Word Press сайт директно на хостинг т.е. Не използвам локален сървър за Денвър "репетиции". Така че съм създал поддомейн сайт testiruem.imya. Как мога да направя това "невидим" за търсачките? Можете да използвате robots.txt? Благодаря ви много предварително

Както търсачките получиха =), за да бъда честен - винаги нещо да лопата perefiltrovovayut, там щеше да седна и да се съгласи да работим заедно по общ стандарт - така че всички те имат един комплект и те бяха единен стандарт!

Тук срещнах твърдението, че директивите на robots.txt са правно обвързващи като аксиома. Но това не е вярно! Затворен за сайта в robots.txt първата за директории, които не се нуждаят от индексиране, а след това на отделни страници, които вече net.Bespolezno! След още един апа все още несъществуващи страници висяха в търсенето.

Едва след като се свържете с обратна Platos schutskiny заяви, че те ще направят всичко. Първо, всички стандартни отговори, а след това в писмена форма във форма на Яндекс. И едва след това несъществуващи страници изчезнали.

Така че Yandex поне не винаги се подчиняват на директивите ...

"За да затворите прелистване на индексни страници, сортиране, търсене

От повторенията трябва да се изхвърлят CMS инструменти. например пренасочване 301, етикет отн на = каноничен (което е специално за тази цел е създадена), 404 или мета тагове роботи Noindex ".

Може ли да каже как да се реши проблема с факта, че основната блог страницата може да доведе различни връзки. Например, половин WWW. и половина без WWW. Това би могло да се отрази неблагоприятно на класирането на сайт?

Сергей, добър ден.

Днес, обърна внимание на един съперник, повече от една година на 1-во място в Яндекс.

най-дългата си като robot.txt за Yandex и Google, вероятно 50-100 линии.

Какво мислиш, че той играе важна в проблем?

Сергей, и можете да просто напишете няколко страници тук? Бих искал да донесе на сайта близо до идеалната държава. В началото на май, за закрепване на мобилната версия, и ще бъде приличен. Детайл от всяко море.

mebelona.ru/mebel/krovati/ и mebelona.ru/tip_mebeli/krovati/

Не мога по някакъв начин да убеди на разработчика да се направи пренасочване на главното огледало с WWW. 🙂

Благодаря ви много, Сергей! Копирайте отговор на възложителя. Той Htaccess, така че тя не смееше да се изкачи. Вече Slazit пъти. ))

Добре дошли! Кажете ми, моля, малко.

Когато е напълно затворен вече в търсене и индекс на сайта на в откъси за екстрадиция се появи фрази а ла "Сайтът е затворен от индексиране." Мога ли по някакъв начин да се избегне това? Направете го така, че дори и след затварянето на фрагментите от индексирането е останал същият.

Добър ден.

Имам същия проблем като в Makar, само че не съм търсене на сайта по никакъв :( търсачката.

Първоначално, също не съм била конфигурирана robots.txt, но след това направи и добави карта на сайта.

След добавяне опитах чрез уебмастър панел в Google и Yandex.

Но никой от свършената не е представила резултатите :(. Уебсайт в заявки Google и Yandex не е :(.

Кажи ми какво друго може да е причината и къде да се копае?